دیپفیک مصنوعی (deepfake AI)؛ایجاد تصویر، صدا و ویدیوجعلی/ لزوم برخورد جدی با سوء استفاده کنندگان در ایران

دیپفیک مصنوعی یک نوع هوش مصنوعی است که برای ایجاد تصاویر، صدا و ویدیوهای جعلی و متقاعدکننده استفاده میشود. این اصطلاح هم تکنولوژی مربوطه و هم محتوای جعلی نتیجهاش را توصیف میکند و از ترکیب دو واژه "یادگیری عمیق" و "تقلب" تشکیل شده است.

مسلم حقیقیان؛ دیپفیکها اغلب محتوای مبدا موجودی را تغییر میدهند جایی که یک فرد با فرد دیگری جایگزین میشود. همچنین محتوای کاملاً اصلی ایجاد میکنند که یک فرد را نشان میدهد که کاری را انجام داده یا چیزی را گفته که واقعاً انجام نداده یا گفته است.

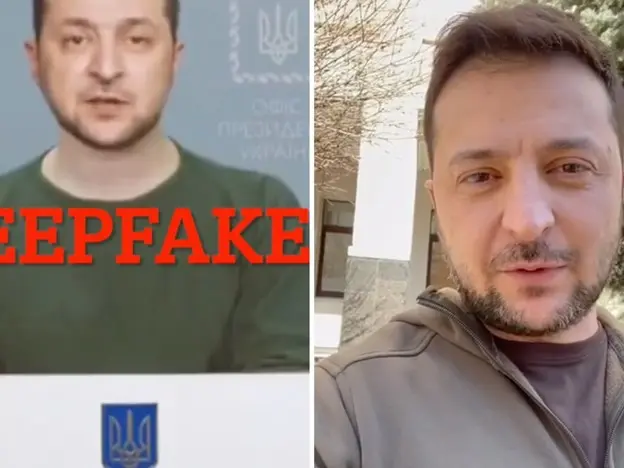

بزرگترین خطری که دیپفیکها ایجاد میکنند، قابلیت انتشار اطلاعات غلطی است که به نظر میآید مبتنی بر منابع قابل اعتماد هستند. به عنوان مثال، در سال 2022 ویدیویی دیپفیک از رئیسجمهور اوکراین، ولودیمیر زلنسکی، منتشر شد که او را به سربسر تسلیم شدن خواست.

نگرانیها همچنین نسبت به امکان مداخله در انتخابات و تبلیغات انتخاباتی ابراز شده است. در حالی که دیپفیکها تهدیدات جدی را ایجاد میکنند، از آنجایی که مصارف مشروعی هم دارند، مانند صداهای بازی و سرگرمی و نرمافزارهای پشتیبانی مشتری و پاسخ به تماس، مانند انتقال تماس و خدمات مسئولیت پذیری، نیز به کار میروند.

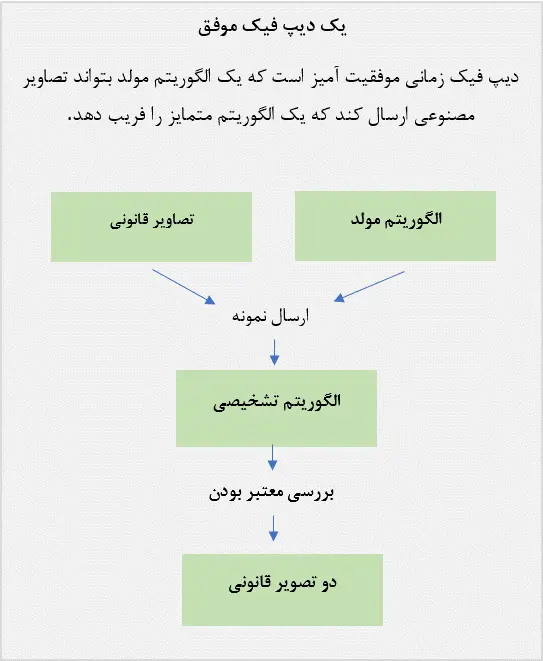

دیپفیکها چگونه کار میکنند؟

دیپفیکها از دو الگوریتم - یک مولد و یک تفاوتیاب - برای ایجاد و بهبود محتوای جعلی استفاده میکنند. مولد مجموعه داده آموزش را بر اساس خروجی مورد نظر ایجاد میکند و محتوای دیجیتال جعلی اولیه را ایجاد میکند، در حالی که تفاوتیاب تحلیل میکند که نسخه اولیه محتوا چقدر واقعی یا جعلی است. این فرآیند تکرار میشود که به مولد اجازه میدهد تا در ایجاد محتوای واقعیتر ماهرتر شود و تفاوتیاب نیز ماهرتر در شناسایی نقصها برای مولد برای اصلاح شود.

ترکیب الگوریتمهای مولد و تفاوتیاب یک شبکه مولد مخاصمانه ایجاد میکند. یک GAN از یادگیری عمیق برای شناختن الگوها در تصاویر واقعی استفاده میکند و سپس از آن الگوها برای ایجاد محتوای جعلی استفاده میکند. هنگام ایجاد یک تصویر دیپفیک، یک سیستم GAN تصاویر هدف را از زوایا وجودی مختلف میبیند تا تمام جزئیات و نقاط نظر را ثبت کند. هنگام ایجاد یک ویدیو دیپفیک، GAN ویدیو را از زوایا و نیز رفتار، حرکت و الگوهای گفتار تحلیل میکند. این اطلاعات سپس چندین بار از طریق تفاوتیاب اجرا میشود تا واقعیت تصویر یا ویدیو نهایی را به نظر سنجد. ویدیوهای دیپفیک به یکی از دو روش ایجاد میشوند. آنها میتوانند از منبع ویدیوی اصلی هدف استفاده کنند، جایی که شخص به انجام دادن کارها و گفتن چیزهایی که واقعاً انجام نداده است، و یا میتوانند چهره افراد را بر روی ویدیوی فرد دیگری جایگزین کنند، که همچنین به نام تعویض چهره شناخته میشود.

در زیر، چند رویکرد خاص برای ایجاد دیپفیکها آورده شده است:

-

دیپفیکهای ویدیوی مبدا: هنگام کار با ویدیوی مبدا، یک دیپفیک autoencoder مبتنی بر شبکه عصبی تحلیل محتوا را انجام میدهد تا ویژگیهای مرتبط با هدف را مانند عبارات چهره و زبان بدنی درک کند. سپس این ویژگیها را به ویدیو اصلی اعمال میکند. این autoencoder شامل یک کدگذار است که ویژگیهای مرتبط را کدگذاری میکند؛ و یک کدگشا که این ویژگیها را به ویدیو هدف اعمال میکند.

-

دیپفیکهای صوتی: برای دیپفیکهای صوتی، یک GAN صدای یک شخص را کلون میکند، یک مدل براساس الگوهای صدایی ایجاد میکند و از آن مدل برای ایجاد صدایی استفاده میکند که خالق میخواهد. این تکنیک معمولاً توسط توسعهدهندگان بازیهای ویدیویی استفاده میشود.

-

هماهنگی لبها: هماهنگی لبها یک تکنیک دیگر رایج در دیپفیکها است. در اینجا، دیپفیک یک ضبط صدا را با ویدیو مپ میکند تا به نظر برسد که فرد در ویدیو کلمات ضبط شده در ویدیو را تلفظ میکند. اگر صدای خود ضبطی نیز دیپفیک باشد، ویدیو لایهای دیگر از فریب اضافه میکند. این تکنیک توسط شبکههای عصبی بازگردنده پشتیبانی میشود

فناوری مورد نیاز برای توسعه دیپ فیک با توسعه و پیشرفت فناوریهای زیر، توسعه دیپفیک آسانتر، دقیقتر و رایجتر میشود.

-

فناوری شبکه عصبی GAN در توسعه تمام محتوای دیپ فیک با استفاده از الگوریتم های مولد و تمایز استفاده می شود.

-

شبکه های عصبی کانولوشنال الگوها را در داده های بصری تجزیه و تحلیل می کنند. CNN ها برای تشخیص چهره و ردیابی حرکت استفاده می شوند.

-

رمزگذار خودکار: یک فناوری شبکه عصبی است که ویژگیهای مربوط به یک هدف مانند حالات صورت و حرکات بدن را شناسایی میکند و سپس این ویژگیها را به ویدیوی منبع تحمیل میکند.

-

پردازش زبان طبیعی برای ایجاد صدای دیپ فیک استفاده می شود. الگوریتمهای NLP ویژگیهای گفتار هدف را تجزیه و تحلیل میکنند و سپس متن اصلی را با استفاده از آن ویژگیها تولید میکنند.

-

محاسبات با کارایی بالا نوعی از محاسبات است که توان محاسباتی لازم قابل توجه مورد نیاز دیپ فیک را فراهم می کند. بر اساس گزارش وزارت امنیت داخلی ایالات متحده "تهدید فزاینده هویت های عمیق"، چندین ابزار معمولاً برای تولید دیپ فیک در عرض چند ثانیه استفاده می شوند.

این ابزارها عبارتند از Deep Art Effects، Deepswap، Deep Video Portraits، FaceApp، FaceMagic، MyHeritage، Wav2Lip، Wombo و Zao.

دیپ فیک معمولا چگونه استفاده می شود؟

استفاده از دیپ فیک به طور قابل توجهی متفاوت است. کاربردهای اصلی شامل موارد زیر است:

-

هنر: دیپ فیک برای تولید موسیقی جدید با استفاده از بدنه های موجود آثار یک هنرمند استفاده می شود.

-

باج گیری و آسیب به شهرت: نمونه هایی از این موارد زمانی است که یک تصویر هدف در موقعیتی غیرقانونی، نامناسب یا به گونه ای دیگر مانند دروغ گفتن به عموم، درگیر شدن در اعمال جنسی آشکار یا مصرف مواد مخدر قرار می گیرد. این ویدئوها برای اخاذی از یک قربانی، خراب کردن شهرت یک فرد، انتقام گرفتن یا صرفاً زورگویی سایبری به آنها استفاده می شود. رایج ترین باج گیری یا استفاده انتقام جویانه، پورن عمیق جعلی غیر توافقی است که به عنوان پورن انتقامی نیز شناخته می شود.

-

خدمات پاسخگویی به تماس گیرندگان این سرویسها: از دیپ فیک برای ارائه پاسخهای شخصی به درخواستهای تماسگیرنده استفاده میکنند که شامل ارسال تماس و سایر خدمات پذیرش میشود. پشتیبانی تلفنی مشتری این سرویس ها از صداهای جعلی برای کارهای ساده ای مانند بررسی موجودی حساب یا ثبت شکایت استفاده می کنند.

-

سرگرمی: فیلمهای هالیوودی و بازیهای ویدیویی صدای بازیگران را برای صحنههای خاصی شبیهسازی و دستکاری میکنند. رسانههای سرگرمی از این ویژگی زمانی استفاده میکنند که صحنهای به سختی فیلمبرداری میشود، در پستولید زمانی که یک بازیگر دیگر برای ضبط صدای خود در صحنه نیست، یا برای صرفهجویی در وقت بازیگر و تیم سازنده. دیپ فیک همچنین برای محتوای طنز و تقلید استفاده می شود که در آن مخاطب متوجه می شود ویدیو واقعی نیست اما از موقعیت طنز آمیزی که دیپ فیک ایجاد می کند لذت میبرد. به عنوان مثال می توان به دیپ فیک سال 2023 دواین «راک» جانسون در نقش دورا کاوشگر اشاره کرد.

-

شواهد نادرست: این شامل ساختن تصاویر یا صداهای نادرست است که می تواند به عنوان مدرکی دال بر گناه یا بی گناهی در یک پرونده قانونی استفاده شود.

-

تقلب: دیپ فیک برای جعل هویت یک فرد برای به دست آوردن اطلاعات شناسایی شخصی (PII) مانند شماره حساب بانکی و کارت اعتباری استفاده می شود. این ممکن است گاهی اوقات شامل جعل هویت مدیران شرکت ها یا سایر کارمندان با اعتبار برای دسترسی به اطلاعات حساس باشد که یک تهدید بزرگ امنیت سایبری است. اطلاعات غلط و دستکاری سیاسی: ویدئوهای دیپ فیک سیاستمداران یا منابع مورد اعتماد برای تحت تاثیر قرار دادن افکار عمومی استفاده می شود و در مورد دیپ فیک رئیس جمهور اوکراین ولودومیر زلنسکی، سردرگمی در جنگ ایجاد می کند. گاهی اوقات از آن به عنوان انتشار اخبار جعلی یاد می شود.

-

دستکاری سهام مواد جعلی: عمیق برای تأثیرگذاری بر قیمت سهام شرکت استفاده می شود. به عنوان مثال، یک ویدیوی جعلی از یک مدیر اجرایی که اظهارات مخربی درباره شرکت خود می کند، می تواند قیمت سهام آن را کاهش دهد. یک ویدیوی جعلی درباره یک پیشرفت تکنولوژیکی یا عرضه محصول می تواند سهام یک شرکت را افزایش دهد.

-

پیامک: در گزارش وزارت امنیت داخلی ایالات متحده با عنوان "تهدید فزاینده هویت های عمیق جعلی"از پیام های متنی به عنوان استفاده آینده از فناوری دیپ فیک یاد شده است. بر اساس این گزارش، بازیگران تهدید میتوانند از تکنیکهای دیپفیک برای تکرار سبک پیامرسانی کاربر استفاده کنند.

روش های تشخیص دیپ فیک

چندین روش برتر برای شناسایی حملات دیپ فیک وجود دارد.موارد زیر نشانههایی از محتوای دیپفیک احتمالی هستند:

-

وضعیت غیرمعمول یا نامناسب صورت

-

حرکت غیر طبیعی صورت یا بدن

-

عدم تناسب صورت با اندام شخص

-

رنگ آمیزی غیر طبیعی ویدیوهایی که با بزرگنمایی یا بزرگنمایی عجیب به نظر می رسند.

-

صدای ناسازگار افرادی که پلک نمی زنند.

در دیپ فیک متنی، چند شاخص وجود دارد:

-

غلط املایی جملاتی که به طور طبیعی جریان ندارند.

-

آدرس ایمیل منبع مشکوک عبارتی که با فرستنده فرضی مطابقت ندارد.

-

پیامهای خارج از متن که به هیچ بحث، رویداد یا موضوعی مرتبط نیستند.

با این حال، هوش مصنوعی به طور پیوسته بر برخی از این شاخص ها غلبه می کند، مانند ابزارهایی که از چشمک زدن طبیعی پشتیبانی می کنند.

نحوه دفاع در برابر دیپ فیک

شرکتها، سازمانها و سازمانهای دولتی، مانند آژانس پروژههای تحقیقاتی پیشرفته دفاعی وزارت دفاع ایالات متحده، در حال توسعه فناوری برای شناسایی و مسدود کردن دیپفیک هستند. برخی از شرکتهای رسانههای اجتماعی از فناوری بلاک چین برای تأیید منبع ویدیوها و تصاویر قبل از ورود آنها به پلتفرمهایشان استفاده میکنند. به این ترتیب، منابع قابل اعتماد ایجاد می شود و از جعلی ها جلوگیری می شود. در همین راستا، فیس بوک و توییتر هر دو دیپ فیک های مخرب را ممنوع کرده اند.

نرم افزار حفاظت Deepfake از شرکت های زیر موجود است:

-

ادوب سیستمی دارد که به سازندگان اجازه میدهد امضایی را به ویدیوها و عکسها با جزئیات مربوط به ساخت آنها اضافه کنند.

-

مایکروسافت دارای نرمافزار تشخیص عمیق جعلی مبتنی بر هوش مصنوعی است که فیلمها و عکسها را تجزیه و تحلیل میکند تا یک امتیاز اطمینان ارائه کند که نشان میدهد آیا رسانه دستکاری شده است یا خیر.

-

عملیات Minerva از کاتالوگهای دیپفیکهایی که قبلاً کشف شدهاند استفاده میکند تا تشخیص دهد که آیا یک ویدیوی جدید صرفاً اصلاح یک جعلی موجود است که کشف شده و اثر انگشت دیجیتالی به آن داده شده است.

-

Sensityیک پلت فرم تشخیص ارائه می دهد که از یادگیری عمیق برای شناسایی نشانه های رسانه های دیپ فیک استفاده می کند، به همان روشی که ابزارهای ضد بدافزار به دنبال امضاهای ویروس و بدافزار هستند. هنگامی که کاربران یک دیپ فیک را مشاهده می کنند، از طریق ایمیل هشدار داده می شود.

نمونه های قابل توجه دیپ فیک

چندین نمونه قابل توجه از دیپ فیک وجود دارد، از جمله موارد زیر:

مارک زاکربرگ، بنیانگذار فیس بوک، قربانی یک دیپ فیک شد که نشان می داد فیس بوک چگونه کاربران خود را "مالک" می کند. این ویدئو برای نشان دادن اینکه چگونه مردم می توانند از پلتفرم های رسانه های اجتماعی مانند فیس بوک برای فریب مردم استفاده کنند طراحی شده است.

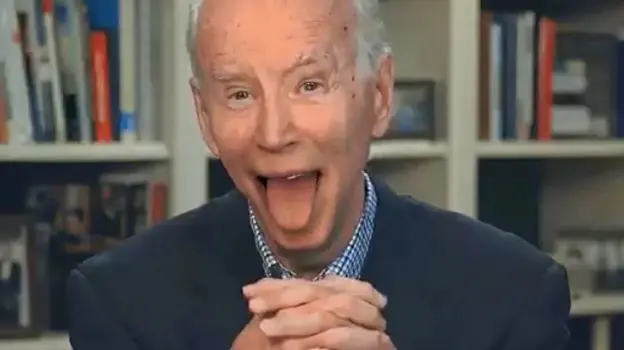

جو بایدن، رئیسجمهور ایالات متحده در سال ۲۰۲۰ قربانی دیپفیکهای متعددی شد که او را در حالات اغراقآمیز زوال شناختی نشان میداد تا بر انتخابات ریاستجمهوری تأثیر بگذارد. رؤسای جمهور باراک اوباما و دونالد ترامپ نیز قربانی ویدیوهای دیپ فیک شده اند که برخی برای انتشار اطلاعات نادرست و برخی به عنوان طنز و سرگرمی هستند.

در طول تهاجم روسیه به اوکراین در سال 2022، رئیس جمهور اوکراین ولودومیر زلنسکی به تصویر کشیده شد که به سربازانش می گوید تسلیم روس ها شوند.

تاریخچه فناوری هوش مصنوعی عمیق

هوش مصنوعی Deepfake یک فناوری نسبتا جدید است که منشاء آن دستکاری عکس ها از طریق برنامه هایی مانند Adobe Photoshop است. در اواسط دهه 2010، قدرت محاسباتی ارزان، مجموعه دادههای بزرگ، هوش مصنوعی و فناوری یادگیری ماشین، همگی برای بهبود پیچیدگی الگوریتمهای یادگیری عمیق ترکیب شدند.

در سال 2014، GAN، فناوری در قلب دیپ فیک ها، توسط محقق دانشگاه مونترال، یان گودفلو، توسعه یافت. در سال 2017، یک کاربر ناشناس Reddit به نام "deepfakes" شروع به انتشار ویدیوهای دیپ فیک از افراد مشهور و همچنین یک ابزار GAN کرد که به کاربران اجازه می داد چهره ها را در ویدیوها عوض کنند. این موارد در اینترنت و شبکه های اجتماعی منتشر شد.

محبوبیت ناگهانی محتوای دیپفیک، شرکتهای فناوری مانند فیسبوک، گوگل و مایکروسافت را بر آن داشت تا روی توسعه ابزارهایی برای شناسایی دیپفیک سرمایهگذاری کنند. علیرغم تلاشهای شرکتهای فناوری و دولتها برای مبارزه با دیپفیک و مقابله با چالش تشخیص دیپفیک، این فناوری همچنان به پیشرفت خود ادامه میدهد و تصاویر و ویدیوهای دیپفیک متقاعدکنندهای را تولید میکند

برنامههای ساخت دیپ فیک رایگان

در حال حاضر بسیاری از ابزارها و سایت ها نیز وجود دارند که به سادگی امکان ساخت تصاویر و ویدیوهای جعلی را توسط علم هوش مصنوعی را برای افراد غیر متخصص نیز فراهم میکنند. البته این ابزارها با سایر اهداف غیر از کلاهبرداری ساخته شده است اما هرشخصی می تواند برای اهداف خود از آن نیز استفاده کند. این ابزارها می تواند عکس شخصی را که شاد است را به شخصی عصبانی تبدیل و آن را برای شما ایجاد کند تا از آن تصویر استفاده کنید.

۱- وبسایت Deepfakes

با سرویس Deepfakes میتوانید ویدیوهای دیپفیک را در بدون نیاز به نصب اپلیکیشن ایجاد کنید. برای اینکه این سرویس بتواند بهکمک یادگیری عمیق، تمام جزییات پیچیدهی تصویر و ویدئویی را که آپلود کردهاید، یاد بگیرد، حداکثر به ۴ ساعت زمان نیاز دارد. تعویض چهرهها با کمک مدل آموزش دیدهی سرویس نیز ۳۰ دقیقه طول خواهید کشید. نسخهی رایگان Deepfakes، ویدیوی خروجی را تا حدود ۵ ساعت بعد آماده میکند، اما نسخهی پولی تنها یک ساعت زمان لازم دارد.

اگرچه این سرویس از پردازندههای گرافیکی قدرتمندی در فضای ابری استفاده میکند، کماکان برای رندر کردن تمام دادهها به ساعتها زمان نیاز دارد. این نشان میدهد که ساخت ویدیوی دیپفیک کار آسانی نیست و بههمین خاطر است که اپلیکیشنهایی مثل Zao که تنها در چند ثانیه، ویدیوی دیپفیک درست میکنند، اینقدر سروصدا به پا میکنند.

۲- اپلیکیشن Wombo

این یکی را احتمالا میشناسید و کلیپهایی را که با آن ایجاد شده، در گوشهوکنار اینترنت دیدهاید. Wombo اپلیکیشنی برای همگامسازی حرکات لب است که به شما اجازه میدهد تصویر خود یا اشخاص دیگر را به ویدیویی تبدیل کنید که در آن لبهایتان حرکت میکند، انگار دارید آواز میخوانید. این اپلیکیشن، ۱۵ آهنگ پیشفرض ارائه میدهد که میتوانید با تمام آنها از تصویر موردنظر خود دیپفیک بسازید.

۳- اپلیکیشن Reface

اپلیکیشن ساخت دیپفیک Reface که ابتدا با نام Doublicat شناخته میشد، به شما امکان میدهد میمهای خندهدار با فرمت گیف درست کنید. این اپلیکیشن از هوش مصنوعی Reface AI کمک میگیرد که درواقع نوعی شبکه مولد رقابتی است. برای استفاده از این اپ تنها کافی است از خودتان عکس بگیرید و بعد فایل گیف مورد نظرتان را از بین میلیونها گیفی که در اینترنت موجود است، انتخاب کنید تا در عرض چند ثانیه، اپلیکیشن Reface چهرهی شما را روی گیف قرار میدهد.

البته در نظر داشته باشید که کیفیت گیفهای ایجاد شده همیشه خوب نیست و به میزان تطابق چهره با گیف بستگی دارد.

۴- اپلیکیشن MyHeritage

یکی دیگر از اپلیکیشنهای دیپفیک که در شبکههای اجتماعی محبوبیت زیادی پیدا کرد، MyHeritage نام دارد؛ چراکه به کاربران امکان میدهد عکسهای قدیمیشان را متحرک کنند. برای استفاده از این سرویس تنها کافی است عکسی را آپلود کرده و دکمهی Animate را فشار دهید.

این اپلیکیشن در عرض چند ثانیه، یک نسخهی متحرک از تصویر شما را تحویل میدهد که در آن چهره، چشمها و دهان حرکت میکنند؛ درست شبیه عکسهای جادویی روزنامهی The Daily Prophet در دنیای هری پاتر!

۵- نرمافزار DeepFaceLab

DeepFaceLab نرمافزاری است که به شما امکان میدهد در محیط ویندوز، ویدیوهای دیپفیک باکیفیتی بسازید. این نرمافزار در درجه اول برای پژوهشگران و دانشجویان بینایی ماشین در نظر گرفته شده است. بااینحال، اگر دوست دارید از ویدیوهای دیپفیک بیشتر سر در بیاورید، میتوانید از این ابزار استفاده کنید. DeepFaceLab از یادگیری ماشین و تلفیق تصویر انسانی برای جایگزین کردن چهرهها در ویدیو استفاده میکند.

از آنجاییکه DeepFaceLab ابزار پیشرفتهای برای پژوهشگران است، رابط کاربری پیچیدهای دارد و برای استفاده از آن باید کمی مطالعه کنید. همچنین، برای رندر کردن ویدیو، به کامپیوتری با پردازنده گرافیکی مجزای قدرتمندی نیاز دارید. اگر دانشجوی بینایی ماشین هستید، DeepFaceLab میتواند ابزار فوقاعلادهای برای درک ویدیوهای دیپفیک باشد.

نتیجه گیری:

پیشرفت علم و تکنولوژی علاوه بر اینکه باعث پیشرفت و راحتی انسانها میشود، می تواند به همان اندازه باعث ایجاد جرم و اختلال در جامعه شود. به طور مشخص مردم نمی توانند جلوی کلاهبرداران در این حوزه بگیرند و تنها شرکتهای مرتبط با مبحث امنیت سایبری و پلیس فتا و دولت است که با بهره گیری از نیروهای انسانی متخصص در این حوزه بتواند از به وجود آمدن جرایم مختلف سایبری جلوگیری کند. در حالی که جلوگیری از این مبحث در کشورهای مختلف به شدت درحال پیشروی است کشور ما ایران هنوز به طور تخصصی حتی وارد این حوزه نشده است و اینکه در سال چند نفر قربانی عملیات دیپ فیک میشود کاملا نامشخص است. امیدواریم که در آینده نه چندان دور در کشور عزیزمان ایران هم شاهد قدمهایی برای جلوگیری به وقوع پیوستن این موضوع در سطح کشور شویم. (..............................)

برای ورود به کانال تلگرام فرتاک نیوز کلیک کنید.